如何培养自己的领导力? 如何培养自己的

这几天学习了B站上Andrej Karpathy的演讲,State of GPT,详细讲述了如何从训练一个基础模型开始到ChatGPT的过程,通俗易懂,内容也很精彩。特对视频的内容总结如下。

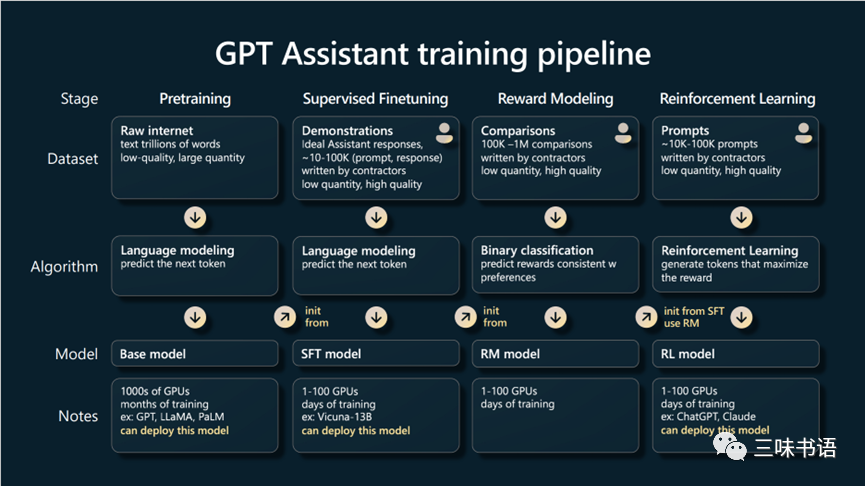

1.ChatGPT训练的四个阶段

一图胜千言,Andrej展示的PPT如下图。

(1)预训练(Pretraining),产出为基础模型(Base model),占据了整个训练过程时间的99%。这个阶段所需的GPU资源和时间数量级为,千张GPU、几个月的训练时长、花费几百万美元。以LLaMA-65B模型训练为例,使用了2048张A100 GPU、21天和花费了500万美元。

(2)有监督微调(Supervised Finetuning),产出为有监督微调(SFT model,Supervised Finetuning model)模型。这个阶段所需的GPU资源和时间数量级为,百卡GPU,几天的训练时长。

(3)奖励建模(Reward Modeling),产出为奖励模型(RM model)。这个阶段所需的GPU资源和时间数量级为,百卡GPU,几天的训练时长。需要注意的是该模型并不是像其它三个阶段的产出部署使用,而是用在用在第四个阶段中的模型训练过程中。

(4)强化学习(Reinforcement Learning),产出为强化学习模型(RL model)。这个阶段所需的GPU资源和时间数量级为,百卡GPU,几天的训练时长。

OpenAI讲的RLHF(Reinforcement Learning from Human Feedback)=奖励建模+强化学习。按照Andrej在演讲中提到的,RLHF模型在某些情况下并不是对基础模型的严格改进,相比基础模型,RLHF模型失去了一些信息熵,这意味着RLHF模型给出了更多的峰值结果。ChatGPT就是一个RLHF模型。

2.Tokenization

这个词一直不知怎么翻译比较好,翻译成“标记化”只能说还凑合。模型训练的输入是文本(Raw text),必须转换为整数才能输入模型训练,这个过程称之为标记化,典型的标记化算法是Byte Pair Encoding。基于Andrej的演讲,推测他们用到的词汇表大小是50,257 个标记(Tokens)。如下图所示。

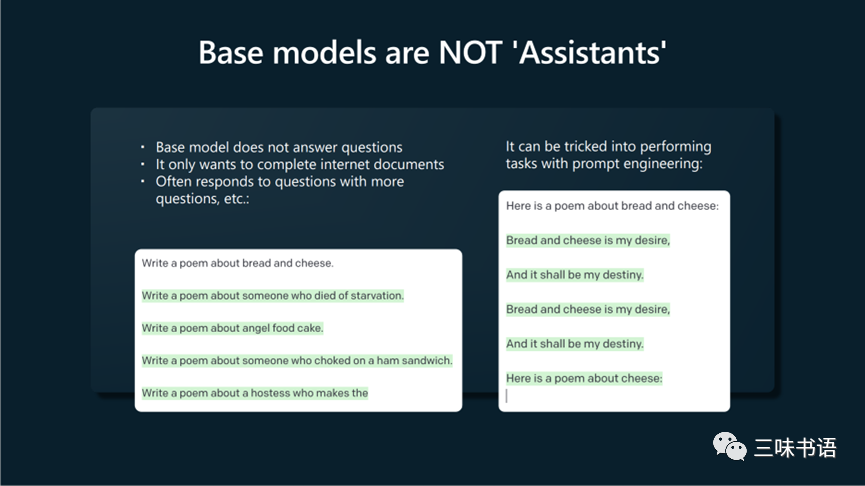

3.Base models are not‘Assistants’(ChatGPT)

ChatGPT是以QA的方式完成交互和任务,而基础模型仅仅是完成一篇文档。按照Andrej的说法你可以通过一些提示使其看起来像是个助手,但实践过程中并不可靠。如下图所示。

4.SFT模型阶段需要的训练数据集是QA对,数量少但质量要求高。

Andrej在演讲中还阐述了个观点,把当前的大语言模型比喻为人类思考模式的系统一(快系统)。其它的演讲细节可参考B站视频。