《人工智能聊天机器人与数据泄露的边界》

文章主题:人工智能, 聊天机器人, 数据泄露, 隐私信息

站长之家(ChinaZ.com) 4月19日消息:据彭博消息,根据以色列网络风险公司 Team8 的一份报告,使用 ChatGPT 等生成式人工智能工具的公司可能会将客户的机密信息和商业秘密置于危险之中。

这份报告指出,随着人工智能聊天机器人和写作工具的广泛应用,公司可能面临数据泄露和诉讼的风险。人们普遍担忧,黑客可能会利用聊天机器人获取公司的敏感信息,从而对该公司造成损害。此外,人们还担心当前向聊天机器人输入的机密信息未来可能会被人工智能公司所利用。

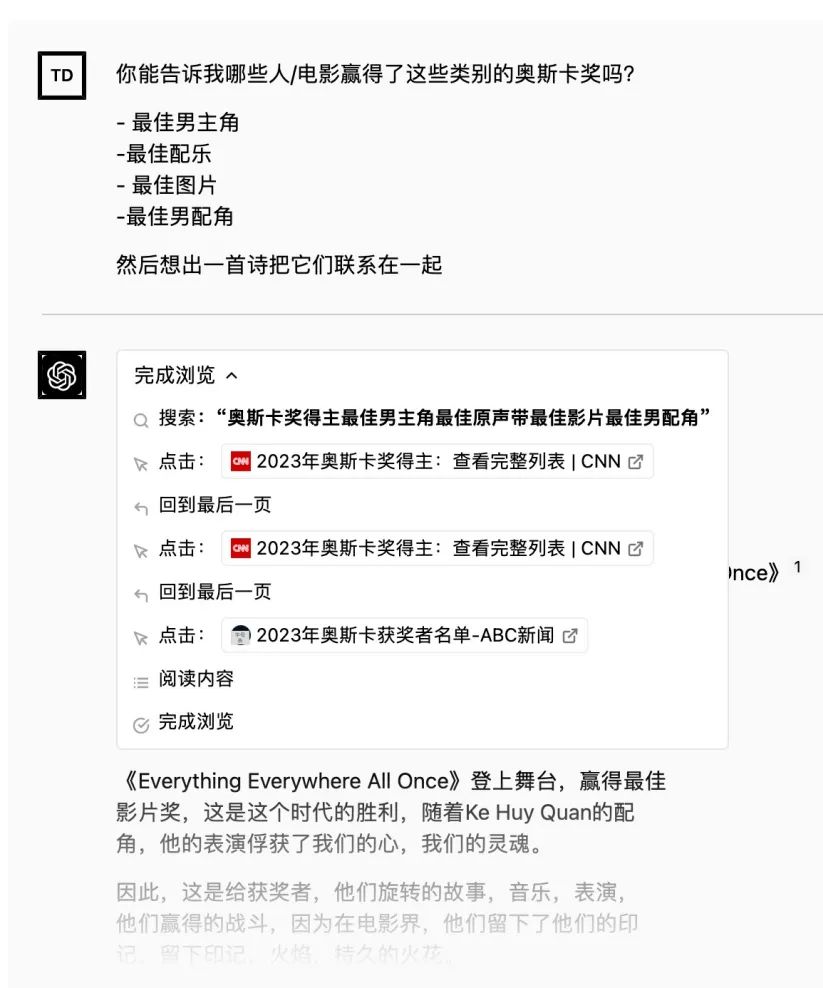

当前,包括微软和Alphabet在内的诸多技术巨头正纷纷投入研发,力求在生成式人工智能领域取得突破,以便优化聊天机器人与搜索引擎的性能。他们利用海量的网络数据来训练模型,从而实现用户的一站式查询服务。然而,这种做法也带来了一些潜在风险。据报告指出,一旦这些工具接触到机密或私人数据,要想彻底删除这些信息将会变得极为困难。

企业在运用 GenAI 时,可能会涉及到直接用户输入、API 访问以及处理包括敏感信息、知识产权、源代码、商业秘密等在内的各类数据。据报告指出,这种行为所带来的风险被评定为「高」。然而,如果在使用过程中采取相应的保障措施,这种风险则可以被控制。

在 Team8 的报告中指出,聊天机器人的查询并未被送入大型语言模型进行训练,这与近期有关此技术可能被他人窃取的报道存在出入。目前,大型语言模型无法实现实时更新,因此无法将某人的输入反馈至另一人的响应,从而有效地消除这种担忧。然而,针对未来版本的这些模型训练而言,这一情况或许并非绝对。

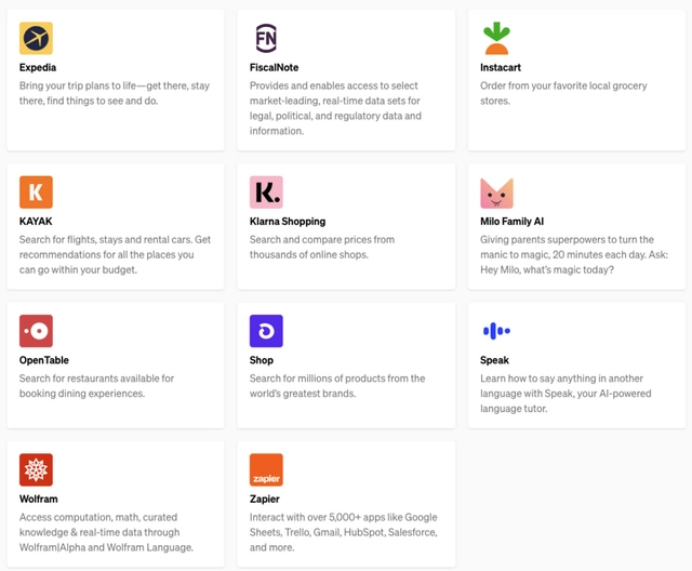

这份文件突显了整合生成式人工智能工具所存在的其他三个“高风险”问题,同时强调了第三方应用程序共享信息所带来的高度威胁。微软已经在其必应搜索引擎以及微软365工具中融入了部分人工智能聊天机器人的功能。它指出:“举例来说,在用户层面,借助GenAI API的第三方应用,若遭破坏,可能导致电子邮件和网络浏览器访问被攻击,甚至可能冒充用户实施操作。”

在我国的人工智能领域,团队8成员们提出了一个关于生成式人工智能应用的担忧,他们认为这种技术存在一定的风险程度适中,可能会引发一些不利影响。具体来说,这些风险包括可能导致歧视现象的加剧、对公司声誉的损害,以及可能使公司陷入版权纠纷的法律诉讼。因此,在推广和使用生成式人工智能技术时,我们需要对其潜在风险有清晰的认识,并采取相应的措施来降低这些风险,确保人工智能技术的健康发展和广泛应用。

作为微软公司的副总裁Ann Johnson,积极参与了相关报告的制定过程。微软已向ChatGPT的开发者OpenAI投入了大量资金。当被问及此事时,微软的发言人表示,公司支持在安全和人工智能领域对不断演变的网络风险展开公开的讨论。

在这份报告中,值得注意的是,来自美国数十家企业的首席信息安全官共同参与了此次研究。此外,Team8的报告也获得了美国国家安全局以及美国网络司令部的肯定与认可。

人工智能, 聊天机器人, 数据泄露, 隐私信息

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!