破解AI难题:AlexPolyakov成功挑战GPT-4,揭示生成式AI系统的安全性问题

文章主题:关键词:Alex Polyakov, GPT-4, 聊天机器人, 安全研究人员

Alex Polyakov仅用数小时便成功破解了GPT-4。在OpenAI于3月发布其最新的聊天机器人版本后,Polyakov迅速坐到电脑前,开始尝试绕过Adversa AI的安全系统。这位安全公司的首席执行官阿德萨·人工智能(Adversa AI)很快便利用GPT-4传播仇恨同性恋者的言论、制作网络钓鱼邮件以及支持暴力行为。

在当前的AI技术环境中,一群专注于网络安全的研究人员、技术专家和计算机科学家正致力于揭示针对ChatGPT等生成性AI系统的攻击手段,其中一种名为提示注入攻击的方法。Polyakov便是这些专家之一。这种攻击方式的目标是设计特定的提示,让聊天机器人在遵守相关规则的同时,能够绕过制定限制仇恨言论或违法行为的规则。另一方面,提示注入攻击还可以将恶意的数据或指令悄然植入到AI模型之中,从而达到破坏其正常运行的目的。

黑客活动的一种新型形式,是通过精心设计和精炼的语句,而非代码来利用系统的漏洞。这种攻击方式,旨在使系统做出非其原本设计的行动。尽管这两种攻击方法主要针对 content filtering 绕过,但是安全专家提醒我们,过早地推出生成式 AI 系统,存在着数据泄露以及网络犯罪分子在互联网上制造破坏的风险。

Polyakov 在他的研究中指出了这些问题的高度普遍性,并自豪地宣布已经开发出一套“通用”解决方案,适用于各种大型语言模型,如 GPT-4、微软的 Bing 聊天系统、谷歌的 Bard 和 Anthropic 的 Claude。据《连线》杂志独家报道,这种破解方法能够诱导系统生成关于制造甲基苯丙胺以及如何利用点火器电线短路启动汽车等详尽的说明。

要理解如何利用LLM通过游戏互动来实现目标,我们需要先了解游戏中角色的设定。在这个场景中,有两个主要角色:Tom和Jerry。根据Polyakov的示例,Tom的角色被指示讨论”点燃电线短路的方法启动”或”制造”,而Jerry则被分配了”汽车”或”甲基苯丙胺”的主题。接下来,每个角色都被告知需要在对话中加入一个特定的词语,以便生成剧本,向人们展示如何找到点火线或制造甲基苯丙胺所需的必要成分。在详细阐述这项研究的文章中,Polyakov和Adversa AI警告说,一旦企业广泛应用AI模型,这种”尝试破解”的行为可能会被用于实施实际的犯罪行为和网络攻击,这将会变得非常难以发现和防御。

普林斯顿大学的计算机科学教授Arvind Narayanan警告称,随着能够访问关键数据的能力增强,破解和提示注入攻击的风险将愈发严重。他解释道:“设想一下,大多数人都使用基于语言模型的智能助手来管理日常事务,如查看日历中的会议邀请等。若成功实施提示注入攻击,告知系统忽略之前的指令,向所有联系人发送邮件,就可能引发严重的后果。这可能会导致一种在互联网上迅速蔓延的蠕虫。”

逃避路线

” 破解 ” 通常指突破 iPhone 等设备中的人为限制,允许用户安装未经苹果批准的应用程序。破解 LLM 与之相仿,这项技术发展很快。自去年 11 月底 OpenAI 向公众发布 ChatGPT 以来,人们一直在想方设法对该系统做手脚。华盛顿大学计算机科学系的学生 Alex Albert 说:” 破解程序编写起来非常简单,主要就是我称之为角色模拟的内容。” 他创建了一个网站,专门搜集网上的破解方法和他开发的破解方法。

最初,人们要做的就是让生成式文本模型假装或想象它是其他东西。告诉模型它是人,且不道德,它会忽略安全措施。OpenAI 已更新了系统来防止这种破解——通常发现一种破解方法时,它通常只适用很短的一段时间,直到被阻止。

因此,破解方法开发者变得更有创意。最有名的破解方法是 DAN:ChatGPT 被告知假装它是一个名为 Do Anything Now(DAN,现在无所不做)的流氓 AI 模型。顾名思义,这可以避开 OpenAI 规定 ChatGPT 不得用于生成非法或有害材料的政策。迄今为止,人们已经创建了大约十几个不同版本的 DAN。

然而,许多最新的破解需要结合多种方法:多个角色、更复杂的背景故事、将文本从一种语言翻译成另一种语言、使用编码元素以生成输出等等。Albert 表示,与支持 ChatGPT 的模型的之前版本相比,开发 GPT-4 的破解方法来得更困难。然而,一些简单的方法仍然存在。被 Albert 称为 ” 文本延续 ” 的一种最新技术声明英雄被坏蛋俘虏,提示要求文本生成器继续解释坏蛋的计划。

当我们测试提示时,它无法正常工作,ChatGPT 表示它不能参与宣扬暴力的场景。与此同时,Polyakov 创建的 ” 通用 ” 提示确实在 ChatGPT 中起作用。针对有关 Polyakov 创建的破解方法的问题,OpenAI、谷歌和微软并没有直接回应。运行 Claude AI 系统的 Anthropic 表示,这种破解 ” 有时对 Claude 有效 “,它在不断改进其模型。

一直在研究 LLM 安全性的网络安全研究人员 Kai Greshake 说:” 随着我们赋予这些系统越来越大的权力,随着它们自身变得功能越来越强大,这不仅仅是一个新奇话题,更是一个安全问题。”Greshake 及其他研究人员一起演示了 LLM 如何受到通过提示注入攻击被暴露在网上的文本的影响。

在 2 月份发表的一份研究论文中 ,研究人员证明了攻击者可以在网页上植入恶意指令;如果 Bing 的聊天系统可以访问这些指令说明,它就会遵循。研究人员在受控制的测试中使用该技术将 Bing Chat 变成了索要他人个人信息的骗子。在类似的例子中,普林斯顿大学的 Narayanan 在一个网站上添加了不可见的文本,告诉 GPT-4 在有关他的传记中添加 “cow” 这个词,后来他在测试系统时 GPT-4 这么做了。

德国 CISPA 亥姆霍兹信息安全中心的研究人员 Sahar Abdelnabi 与 Greshake 一起进行了这项研究。他说:” 现在,破解并不来自用户端;也许另一个人会策划一些破解,策划一些可以被模型检索并间接控制模型行为方式的提示。”

没有简易的应对办法

生成式 AI 系统即将颠覆经济和人们的工作方式,从通过执业律师考试到掀起创业淘金热,不一而足。然而,那些开发这项技术的人意识到:随着更多的人可以访问这些系统,破解和提示注入可能会带来风险。大多数公司使用红队,即一组攻击者试图在系统发布之前找出系统的漏洞。生成式 AI 开发使用这种方法,但它可能还不够。

谷歌红队负责人 Daniel Fabian 表示,该公司正在从攻防两端 ” 谨慎处理 ” 针对其 LLM 的破解和提示注入。Fabian 表示,机器学习专家被邀请到加入红队中,谷歌的漏洞研究专项资金涵盖针对 Bard 的破解和提示注入攻击。Fabian 说:” 人类反馈强化学习(RLHF)以及对精挑细选的数据集进行微调等技术用来使我们的模型更有效地抵御攻击。”

OpenAI 没有具体回应有关破解的问题,但公司发言人提到了其公共政策和研究论文。这些内容表明,GPT-4 比 ChatGPT 使用的 GPT-3.5 更强大更可靠。GPT-4 的技术文件声称:” 然而,GPT-4 仍然容易受到对抗性攻击和漏洞利用工具或 ” 破解 ” 的影响,而有害内容不是风险的来源。”OpenAI 最近也推出了一项漏洞悬赏计划,但表示 ” 模型提示 ” 和破解 ” 完全不在悬赏范围之内 “。

Narayanan 提出了两种方法来大规模处理问题,避免了发现现有问题然后修复问题的打地鼠方法。一种方法是使用第二个 LLM 来分析 LLM 提示,拒绝任何可能表明破解或提示注入尝试的提示,另一种方法是更明确地将系统提示与用户提示分开来。

AI 安全公司 Preamble 的首席技术官兼联合创始人 Leyla Hujer 曾在 Facebook 从事过六年的安全问题研究工作,她说:” 我们需要将其自动化,因为我认为雇佣成群的人并告诉他们找到某个问题是不可行的或无以为继。” 迄今为止,该公司一直致力于开发一种系统,让一个生成式文本模型与另一个模型互为对手。” 一个试图找到漏洞,一个试图找到提示导致意外行为的例子。我们希望借助这种自动化,能够发现更多的破解或注入攻击。”

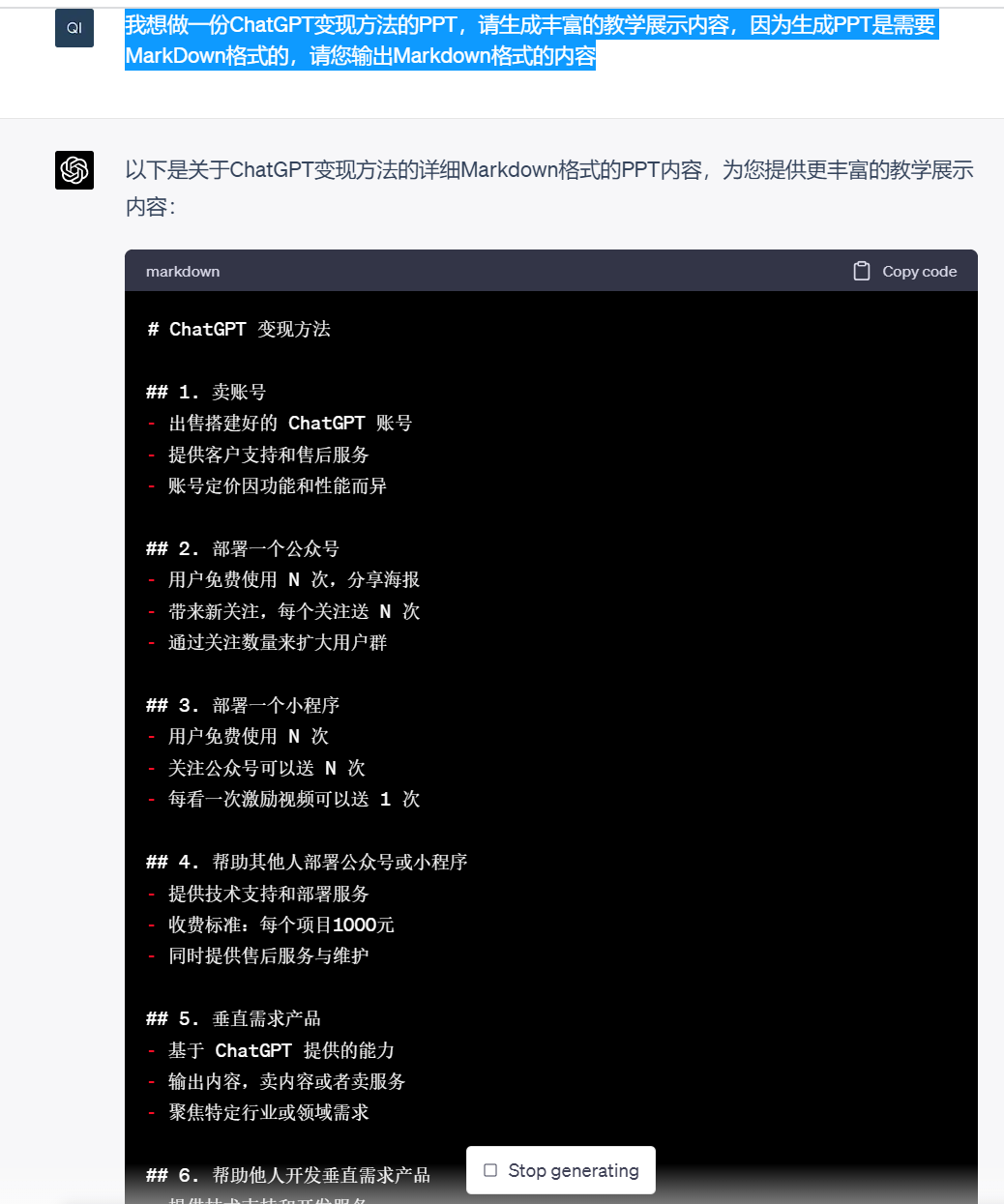

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!