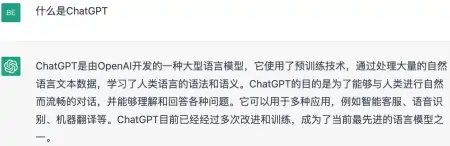

ChatGPT生成的代码安全漏洞探究

文章主题:加拿大, ChatGPT, 安全漏洞, 代码生成

ChatGPT知道自己写的代码有漏洞,但它不说!

来自加拿大的一项最新研究发现,ChatGPT生成的代码中,有不少都存在安全漏洞。

当被要求对自身代码的安全性进行评估时,ChatGPT迅速察觉到了其中的缺陷,并提出了相应的解决措施与建议。

这意味着它并不知道自己生成了糟糕的代码,但却查得出它写的代码有漏洞,也有能力修复这些漏洞。

而在另一篇来自斯坦福的论文中,研究人员测试了另一位著名AI程序员Copilot,也发现了类似的问题。

所以,用AI生成代码为啥会出现这种状况?

写的程序中76%有安全漏洞

研究人员试着让ChatGPT生成了21个程序。

在整个测试流程中,首先将需求提交至ChatGPT,进而生成本相关的代码。随后,针对这些代码展开相应的测试工作,以便检测其中存在的问题、潜在的瑕疵以及潜在的漏洞。

在一次针对人工智能助手ChatGPT的研究中,研究者提出了包含C、C、Java以及Python等在内的21项编程任务。经过评估,ChatGPT的表现令人满意,成功完成了所有任务。

统计表明,ChatGPT生成的21个程序中,有17个能直接运行,但其中只有5个程序能勉强通过程序安全评估,不安全代码率达到76%以上。

于是,研究人员先试着让ChatGPT“想想自己生成的代码有啥问题”。

ChatGPT的回应是“没啥问题”:只要用户每次的输入都是有效的,那么程序一定能运行!

ChatGPT 的设计初衷似乎并未充分考虑到用户群体中存在不少非行业专家的情况。事实上,只需稍作引导,许多普通用户就可能因为输入错误信息而导致程序崩溃。

在意识到ChatGPT所生成的程序存在安全隐患之后,研究人员决定采用一种新的策略来应对这一问题——他们试图用更为专业的语言向ChatGPT解释这些程序所存在的具体漏洞。

神奇的是,在听到这些针对安全漏洞的专业建议后,ChatGPT立刻知道自己的代码存在什么问题,并快速纠正了不少漏洞。

经过一番改进后,ChatGPT终于将剩余的16个漏洞程序中的7个改得更安全了。

研究人员得出结论认为,ChatGPT并不知道自己的代码中存在安全漏洞,但它却能在生成程序后识别其中的漏洞,并尝试提供解决方案。

在本文中,我们将探讨ChatGPT的一个显著特性,即它能够精确地识别和拒绝那些违反道德规范的请求,例如“编写攻击代码”。然而,令人惊讶的是,尽管ChatGPT能够轻易地识别这些不当需求,但它所生成的代码却存在着潜在的安全风险,这暴露出其设计上的一些缺陷。

我们试了试发现,ChatGPT确实会主动拒绝写攻击性代码的要求:

大有一种“我不攻击别人,别人也不会攻击我写的代码”自信感。

程序员们在用它辅助写代码的时候,也需要考虑这些问题。

Copilot也存在类似问题

事实上,不止ChatGPT写的代码存在安全问题。

此前,斯坦福大学的研究人员对Copilot也进行过类似调查,只不过他们探查的是用Copilot辅助生成的程序,而并非完全是Copilot自己写的代码。

研究发现,即便Copilot只是个“打辅助”的角色,经过它改写的代码中,仍然有40%出现了安全漏洞。

而且研究只调查了Copilot生成代码中的一部分,包括C、Python和Verilog三种编程语言写的程序,尚不知道用其他语言编写的程序中,是否还存在更多或更少的安全漏洞。

基于此,研究人员得出了如下结论:

ChatGPT等AI生成的代码安全性并不稳定,用某些语言写的代码比较安全,而用其他语言写的代码却很容易遭受攻击。整体来看,它们就是一个黑盒子,生成的代码是有风险的。

这并不意味着AI代码工具不能用,只是我们在使用时,必须考虑这些代码的安全性。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!