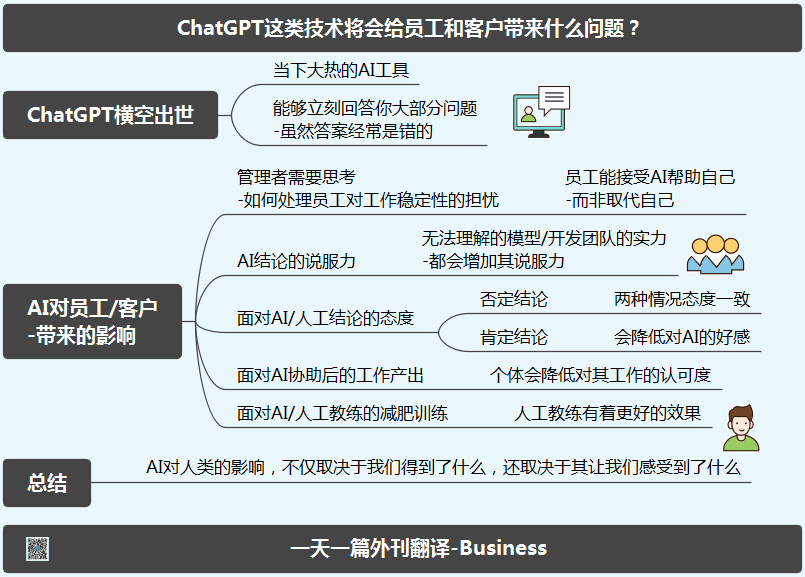

《AIGC竞赛:无脑扩大模型规模已过时?》

文章主题:自然语言处理, 人工智能, 大规模模型, 模型规模

无脑增加

模型规模

已经落伍

在 ChatGPT 或新 Bing 的平台上,当您输入问题时,AI 便会连接到其云端大脑,经过深思熟虑后,生成一段相对合理的回答。这种人工智能技术具有很高的智能水平,可以为用户提供准确的信息和解答,满足用户在各个领域的需求。

而在 OpenAI 开发 GPT 时,也反复提到了参数正变得庞大,模型的规模也在逐代变得复杂。

要构建大规模的语言模型并对其进行训练,我们需要借助于强大的 GPU 集群。然而,值得注意的是,随着用户数量的急剧增加,这些集群的运算能力也会相应地消耗完毕。因此,为了确保训练的高效性和可持续性,我们需要不断地优化资源分配策略,以便在有限的算力条件下满足更多用户的需求。

对于那些希望加入AIGC领域的公司来说,首要任务似乎是如何构建庞大的云计算中心,这暗示着AIGC竞赛已经变成了硬件资源争夺战。

OpenAI CEO Sam Altman 图片来自:wired

增强的计算能力将使得更大的语言模型和算法得以运行,从而推动AI产品的智能程度提升。

原内容表达了对OpenAI CEO Sam Altman在麻省理工演讲中对那些寻求通过简单力量取得成功的后来者的冷嘲热讽。然而,作为一名文章写作高手,我会以更客观、专业的语言来表达这个观点。近期,OpenAI公司的CEO Sam Altman在麻省理工学院的演讲中,向那些期待通过简单力量实现奇迹的人发出了警告。他的言辞虽然谨慎,但却足以让那些过于自信的后来者清醒过来。

Altman:无脑扩大模型规模已经过时

「大型模型时代已经到头了,我们需要用新的思路和方法,让 AIGC 取得新的进展。」

为了提升模型的性能,OpenAI 在过去的几年中一直致力于扩大其模型规模,采用更为复杂的参数以及调用更大规模的算力。这些策略已经成为 OpenAI 在 GPT 项目上所采用的主要迭代方法。

GPT-2 拥有大约 150 亿参数,而 GPT-3 则具有惊人的 1750 亿参数。至于 GPT-4,尽管尚未官方公布具体参数数量,但据多家机构猜测,它至少使用了数万亿字的文本以及上万台云计算服务器。据悉,训练 GPT-4 的成本已超过 1 亿美元,足见其庞大的规模和复杂度。

随着 ChatGPT 的影响力越来越大,微软也使用了其底层技术,推出了新 bing。

随着科技的不断进步,各大公司纷纷加入人工智能的竞赛,其中Google推出了Bard,Adobe则推出了Firefly。除此之外,在硅谷地区,众多资金充足的初创企业,例如Anthropic、AI21、Cohere和Character.AI等,也在大力投资研发更大规模的人工智能算法,旨在尽快达到ChatGPT和OpenAI的水平。

二代 Runway 一句话生成的大片

对于硬件资源的极大需求,也造成了英伟达 A100、H100 GPU 的抢购潮。

在 eBay 上,英伟达的 H100 已经成热门商品,价格更是炒到了 4 万美元,而其官方售价只是 3.3 万美元。并且,H100 一般是打包 8 张组成一个服务器销售。

目前,并没有其他的第三方对外销售的 GPU 与英伟达竞争,在 AI 浪潮之下,谁的英伟达 GPU 越多,仿佛就掌握了 AIGC 行业的取胜之匙。

与传统行业的资本垄断、大企业垄断类似,对于算力的追求,也催生了「算力垄断」。

而 Sam Altman 也表示,OpenAI 还没有开发 GPT-5 的计划。言下之意便是,无脑的扩大模型规模,并不会让 GPT 保持无限的迭代。

目前来说,ChatGPT 与微软的新 bing 都遇到了不少因为算力不太够而出现宕机、服务不稳定的状况。

同时,新 bing 也并未面向所有用户,「排队等待」的状况仍然存在。

而这也是 Google 还无法将类似的生成式 AI 完全引入其搜索的一个原因。

曾在 Google 从事 AI 工作,现在是 Cohere 创始人的 Nick Frosst 也表示 Altman 很有先见之明,并且也表示,新的人工智能模型设计或架构可能会基于人类反馈进行调整。

按照这个思路来说,OpenAI 或许已经在用新的思路在构思 GPT-5 了。

Musk:挖人、买显卡、组团队入局

即便 Sam Altman 公开表示,现阶段继续走 OpenAI 的老路,通过扩大模型规模来提升,很难追得上 ChatGPT。

但曾是 Altman 的老朋友 Musk,毅然决然地投入到了 AIGC 行业之中。

根据华尔街日报的消息,Musk 悄悄地注册了一家名为 X.AI Crop 的公司,并从 Google 挖了几名研究员,向英伟达买了几千张显卡。

Musk 的目的很明确,就是为了与 OpenAI 和 Google 展开竞争。

就在相关报道发出之后,Musk 在接受 Fox News 采访时,就承认了想要推出一款类似 ChatGPT 的产品,取名为 TruthGPT。

Musk 的意图很明确,TruthGPT 将会「最大化寻求真理的 AI」,并试图理解宇宙的本质,希望能带来更多的好处而不是坏处。

Musk 的采访和回应,其实有点无厘头,毕竟按照现在大语言模型的规模来看,X.AI Crop 可能还不如硅谷的一些初创团队。

且 TruthGPT 这个名字也像是在向 ChatGPT 抗议。

Musk 一直认为 GPT-4 类的生成式 AI 会有相当大的风险,呼吁暂停开发六个月,并且呼吁推出相应的监管。

甚至也说出了「ta 有毁灭文明的潜力」。

只是一边说暂停研究,自己一边成立 X.AI Crop 开始入局 AIGC,很难不相信这是在炒作。

另外,暂停六个月的研发,也更像是封印 OpenAI,给自己留出六个月的时间来迎头追上进度。

不可否认地说,Musk 的 SpaceX、Tesla 都颠覆了一个行业,成为当下名气最响亮的企业。

Musk 与 Starship

而当初离开 OpenAI,看到如今的成就,并用一些比较有争议的言论,反而展示了 Musk 早就错失机会的不甘。

至于 TruthGPT 是否能像他说的那样,只能等六个月再看看了。

黄仁勋:我们需要一个 App

目前生成式 AI 仅存在于对话框中,以一种很古典的形式出现在当下所有的智能设备当中。

不论是插件,还是第三方 App,最终大众与其交互的都是一个个对话文本框。

这也是计算机刚刚出现时,最初级的人机交互方式。

而在 Nicolai Tangen 的一期播客里,他与英伟达 CEO 黄仁勋 畅聊了 AI 将会如何改变人们生活和工作方式。

当下 AI 的快速发展,离不开英伟达的 GPU 的助力,英伟达几乎垄断了云算力的市场。

如 Altman 的观点,当下 AI 还无法摆脱超高算力,超大型模型以及庞大算法的支持。

对于初创公司来说,这是一个挑战,而对于英伟达来说也是。

英伟达需要不断地开发制造更强大的 GPU 来适应 AI 的发展。并且目前 AI 仍然存在于巨大的数据中心,以及需要多台超级计算机提供算力。

它不像此前任何的一个应用程序,或者软件。GPT-3 有着 1750 亿个参数,在面对如此的计算量时,英伟达的 AI GPU 从底层重新进行了设计。

但目前,处理大规模的数据和学习大模型,仍然需要数周的时间。它现在还无法浓缩到一个 App 或者个人 PC 当中。

如此其实也解答了到目前为止 AI 对于软件的促进,其实都是以云和插件的形式存在。

而英伟达也表示,AI 已经开始深入到自己芯片的设计当中,「当芯片架构师在睡觉的时候,AI 仍然在不断地迭代和优化改进相应架构」。

「它能帮助我们更好地设计和制造芯片。」

换句话说,AI 介入芯片的生产,而生产出的芯片又用于云算力来运行 AI,这算是 AI 的自给自足了吧。

另外,黄仁勋也认为 AI 也将会引发下一次工业革命,它暂时不会自我觉醒取代人类。

反而会极大地解放人力,增加每个人的生产力。人们可以利用自然语言直接编程,而无需学习复杂的 Python、Java、C 语言。

并且,他也拿英伟达的软件工程师举例,在 AI 的帮助下,大概有 40~50% 的代码和软件由生成式 AI 补充,工程师只要提供建议与思路。

黄仁勋也预估,AI 的加入,会让目前英伟达软件工程师的生产效率提升 10 倍。

Github 的 Copilot 功能

AI 的介入,能够让人们以一万倍的速度完成很多繁琐的事情,间接提高了生产力。

在 GPT-4 出现之前,AI 行业可以以简单地依靠扩大模型规模,增加硬件部署来保持高速迭代。

随着算力瓶颈的出现,不得不让 OpenAI 重新思考如何优化,找到 AI 的下一步发展方向。

同样地,黄仁勋也清晰地认识到,目前 AI 对于算力的需求过于庞大,且它需要存在于一个空间巨大、芯片众多的位置,现在的 AI 就仿佛像是世界上第一代计算机 ENIAC 一般。

AI 的下一步,减少对资源需求的同时,也需要瘦身,并且能独立存在于一个 App 或者软件当中。

从目前来说,这还不太现实,不过好消息是 OpenAI 已经开始招聘 Android、iOS 工程师,相应的 App 也应该很快就来了。

自然语言处理, 人工智能, 大规模模型, 模型规模

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!