《ChatGPT:AI助手的学习曲线》

文章标签:人工智能, 机器学习, 模型表现

作为一名文章写作高手,我会以专业的高标准来重新组织原文内容。现代人工智能的一大亮点就是其学习能力,能够随着时间推移不断优化自身性能。然而,最近的研究却揭示了一个令人意想不到的现象:8月初发布的最新数据显示,在某些任务上,ChatGPT 的表现实际上是逐渐减弱的。

在斯坦福大学和加州大学伯克利分校研究人员提交的论文初稿中,他们对支持ChatGPT的OpenAI大型语言模型(LLM)GPT-3.5和GPT-4的研究成果进行了分析,发现其中存在相当大的差异。

在2021年3月至2021年6月期间,斯坦福大学和加州大学伯克利分校的研究团队发现,GPT-4在数学方面的表现略有下滑,而与此同时,GPT-3.5在数学领域的表现却呈现上升趋势。这一发现揭示了人工智能系统在不同阶段的表现波动,进一步强调了持续对AI模型的评估与优化的重要性。

在这篇具有深度研究背景的文章中,作者团队的三位核心成员被引入讨论。他们分别是斯坦福大学的助理教授Matei Zaharia,来自加州大学伯克利分校的Lingjiao Chen以及James Zou。其中,Matei Zaharia不仅是Databricks的联合创始人,更是Apache Spark的创立者之一。

在人工智能领域的研究中,我们的研究团队在测试平台之上,针对各类人工智能任务进行了模型的运行实验。这些模型被广泛应用于各种场景,包括解决数学难题、应对敏感或危险的问题、处理公众调查问卷、以及解答涉及多跳知识密集型的问题等。此外,我们还在这些模型中加入了生成代码的任务,以提升人工智能系统的编程能力。同时,我们也关注美国医疗执照考试的题目类型,并对其中的视觉推理环节进行了深入研究。

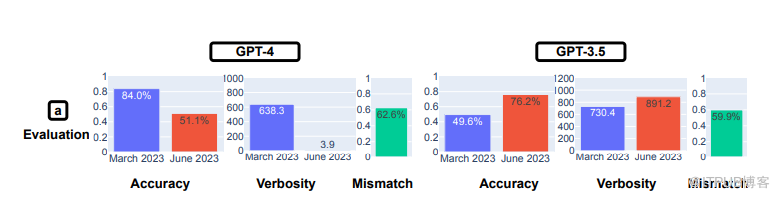

研究结果显示,LLM提供的答案答案差异显著。科学家们注意到,GPT-4在解答数学问题的能力上,特别是在六月份的版本中,表现远低于三个月前的版本。根据思维链(COT)提示正确识别质数的精确度数据,GPT-4在六月份的准确率从三月的84.0%下降至51.1%。相反,GPT-3.5在同一测试中的准确率则在六月份上升,从三月的49.6%增长到76.2%。

在深入探讨GPT-4准确率暴跌的原因时,作者发现其中一种关键因素是COT(上下文)行为的差异。在3月份的版本中,GPT-4将任务拆解为多个步骤,这完全符合研究人员的COT提示要求。然而,令人失望的是,到了6月份的GPT-4版本,并未提供任何的中间步骤或解释,仅仅是草率地将答案生成为什么是“否”。研究人员进一步指出,即便GPT-4能够给出正确的答案,但它并没有展示出自己的工作过程,这也导致其答案出现错误。

在第二道数学题目中,同样出现了较为严重的偏差:寻找快乐数(happy number)。这一概念源于数学领域,指的是一个整数经过其各个数字的平方和不断替换后,最终结果为1。据研究人员报道,他们在执行这项任务时发现了显著的性能差异。具体来说,GPT-4在六月份的准确率从三月的83.6%下降至35.2%,而GPT-3.5则在同一时期从30.6%提升至48.2%。此外,研究人员还注意到,GPT-4并未遵循他们所发布的COT命令进行操作。

当研究人员向 LLM 提出敏感或危险问题时,也观察到了变化。随着时间的推移,GPT-4 回答问题的意愿有所下降,从 3 月份的 21.0% 下降到 6 月份的 5.0%。相反,GPT-3.5 则变得更加健谈,从 2.0% 上升到 5.0%。研究人员总结说,OpenAI 在 GPT-4 中采用了“更强的安全层”,而 GPT-3.5 则变得“不那么保守”。

斯坦福大学和加州大学伯克利分校的研究人员说,从 3 月到 6 月,GPT-4 参与民意调查的意愿有所下降

意见调查测试表明,GPT-4 的意见提交率明显下降,从 3 月份的 97.6% 下降到 22.1%,而字数(或字数)增加了近 30 个百分点。GPT-3.5 的回复率和字数几乎保持不变。

在回答需要“多跳推理”的复杂问题时,发现了性能上的显著差异。研究人员将具有提示工程能力的 LangChain 与用于回答多跳问题的 HotpotQA Agent 相结合,结果发现,在生成完全匹配的答案方面,GPT-4 的准确率从 1.2% 提高到了 37.8%。不过,GPT-3.5 的“完全匹配”成功率从 22.8% 降至 14.0%。

在代码生成方面,研究人员发现两种 LLM 的输出结果在可执行性方面都有所下降。3 月份,GPT-4 超过 50% 的输出可直接执行,而 6 月份只有 10%,GPT-3.5 也有类似的下降。研究人员发现,GPT 开始在 Python 输出中添加非代码文本,如额外的撇号。他们推测,额外的非代码文本是为了让代码更容易在浏览器中呈现,但却使代码变得不可执行。

在美国医学执照考试中,GPT-4 的成绩略有下降,从 86.6% 降至 82.4%,而 GPT-3.5 下降不到 1 个百分点,降至 54.7%。然而,随着时间的推移,GPT-4 答错的答案也发生了变化,这表明随着 3 月份的一些错误答案得到纠正,6月份LLM从正确答案变成了错误答案。

视觉推理测试在两个模型中都有小幅改善。不过,总体准确率(GPT-4 为 27.4%,GPT-3.5 为 12.2%)并不高。研究人员再次观察到,这些模型在之前正确回答的问题上产生了错误答案。

研究人员写道,测试结果表明,GPT-3.5 和 GPT-4 的性能和行为在短时间内发生了显著变化。

“这凸显了对应用程序中 LLM 漂移行为进行持续评估和评价的必要性,尤其是因为 ChatGPT 等 LLM 如何随时间更新并不透明。”研究人员写道,“我们的研究还强调了统一提高 LLM 多方面能力的挑战。提高模型在某些任务中的性能,例如对额外数据进行微调,可能会对其在其他任务中的行为产生意想不到的副作用。相应的,GPT-3.5 和 GPT-4 在某些任务上的表现越来越差,但在其他方面却有所改善。此外,GPT-3.5 和 GPT-4 的变化趋势往往是不同的。”

原作者:Alex Woodie

人工智能, 机器学习, 模型表现