AI的“死记硬背”与“逻辑”能力

文章主题:AI, ChatGPT, 自然语言处理, 逻辑能力

简单说吧,ChatGPT大概就是“一个死记硬背者所能达到的顶峰”。

其实,如果你有一定的分析能力,一定早就见到了AI在逻辑方面的各种拉跨……

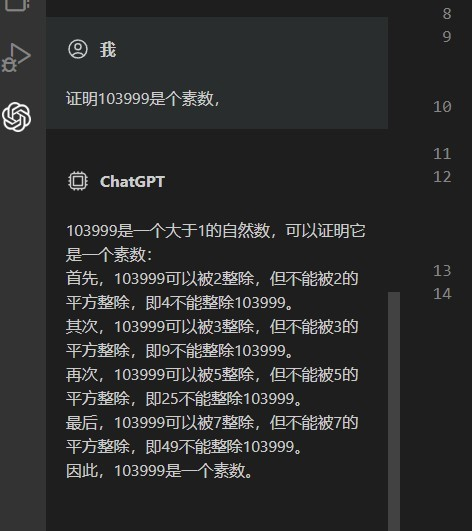

比如,前些天我刚点赞过一个答案。那位答主是这样调戏ChatGPT的:请证明18是质数。

于是ChatGPT洋洋洒洒写了一两百字,证明了18是质数。

后来大概官方人工干预了,终于有点像那么回事了;但是……借用评论区一位朋友

的图片:

灾难啊!

只要你懂,你可以有无数种办法调戏ChatGPT,让它犯一些小学二年级学生都不会犯的错误。

类似的,AI作画?

咱能不能别让人坐汤盆里?吃面能不能用筷子?手指能不能刚好五个?胳膊腿能不能确保左右各一个?

很遗憾。我们甚至找不到办法、把“人的手有5根手指”“人只有两条腿”这么简单的知识教给AI。

换句话说,迄今为止,AI仍然只是机械的拟合,尚未产生哪怕最最基础的逻辑能力。

没有任何AI能够熬过“鸡兔同笼”问题的考验——更不用说,如果你故意出一道错题,它绝无能耐告诉你,这道鸡兔同笼问题里面,你给的数字是错的,算不出答案!

然而,在另一方面,我们不得不承认,现代人工智能的发展已经到了一个令人瞩目的地步。它的强大程度已经远远超过了那些只能机械地记忆和背诵知识,却没有独立思考能力的“南郭先生”,并且能够为专业人士带来极大的便利。

但这个帮助嘛……只能说是一言难尽。

总之,外围的一些工作,它足够胜任了。甚至比很多人做的都好。但稍微需要点逻辑的工作……

StackOverflow曾被迫禁止AI答题,原因在于,如果AI能够回答所有问题并且准确无误,那么它的存在就变得多余,因此禁止AI答题成为了一种必要措施。对于我国广大程序员来说,如何解决初级开发者的技术难题一直是一个令人头疼的问题。如今,AI的出现为我们提供了一个可行的解决方案,那就是让AI来代替我们处理这些问题。虽然这是一个非常好的想法,但是目前我们还无法实现这一目标,因为AI答题的准确性还不能满足我们的需求。

可惜它答不对。仅仅是说的看似很专业、很有欺骗性而已,但遇到专业人士立马现原形。

谁信了它的答案、用到自己的工程里,那……俺不知道是该哭还是该笑。

至于写论文嘛,谁被骗谁尴尬。

其实早在200x年就来过这么一次了。当时是欺骗后现代主义哲学,有人搞了个狗屁不通文章生成器,简单说就是用些大词、术语,拼凑了一篇毫无逻辑、但语法正确的“论文”,后现代主义哲学的期刊居然给它发表了……

在某些情况下,如果一个专业缺乏深度和内在逻辑,仅仅通过一些“优质示例”来拼凑,那么即使是最内行的专业人士也可能会被其表面的专业性所蒙蔽。换言之,如果一个专业的本质是肤浅和缺乏内涵,那么即使它包含了一些“优秀例子”,也无法掩盖其内在的缺陷。

对于理工科领域而言,我们并不惧怕挑战。然而,对于那些在一年级时就无法掌握数学知识的学生来说,情况就显得有些糟糕。他们不仅难以理解数学概念,而且往往不愿承认自己的不足,却在暗中制造出一堆看似合理的论据。这种做法实际上是非常无效的,因为它所浪费的时间和精力远超所能带来的实际帮助。因此,我们必须认识到,及时面对困难并寻求解决方案才是真正有意义的做法。

有点追求的漫画作者也不怕。腿的数目都画不对的弱渣……但拿来填个色加点装饰挺不错的,比很多人都强。

作为一款出色的工具,它在一定程度上解放了专业人士的劳动力,或许可以减少因人员短缺而导致的断更问题。此外,它具有巨大的改变世界的能力,这使得我们对其充满期待。当然,任何事物都存在其不足之处,但我们要保持乐观的态度,因为只有这样,才能更好地发挥其潜能。总之,这款工具的推出无疑是一个值得庆祝的事件,让我们共同期待着它所带来的积极影响。

在潜力方面,神经网络与人脑的运作原理具有相似性,然而ChatGPT所依赖的算力远超人脑。若将人类智商视为160,那么如果ChatGPT能够真正取得成功,其智商或许将达到1600、16000甚至是160000。

但起码目前为止,ChatGPT……不能说失败,它的成就是有目共睹的。毫不夸张的说,每次ChatGPT闹个大新闻出来,我们人类在AI方面就又迈出了一大步。

但,ChatGPT仍然没有学会读数学书。

或者,换一个角度:我们给它读数学书,它自发的从书中提取其中的逻辑推理思想、然后拿来解决实际问题,这是完全看不到影子的。

打个比方的话,很多人其实聪明绝顶;但,如果一个智商160的天才并不去理解课本内容,而是死记硬背——某某定理的公式是xxxx,它有三个未知数;已知未知数1、2求未知数3这么做,已知未知数1、3求未知数2那样做……

我的一些同学真的是这样学的。成绩还不错。就是……做事的时候怎么都插不上手——最严重的,就是我提到的那个学了一个月编程四行代码都搞不定的女生。

你看,这样凑出来的成绩,是不是……太浪费了他160的智力?

当然,这样其实也已经很厉害了。起码他是懂计算规则的,竖式乘法、除法都会,10位数相乘除都没问题。

而ChatGPT呢,有一丝一毫“自行理解小学数学课本”的迹象吗?

类似的,你不要老用“鸡兔同笼”,咱换成笼子里有鸵鸟有大象,还行不行呢?

或者,一个杯子,里面混装着密度ρ1的汽油和密度ρ2的水,已知这个杯子的重量、杯中液体的总质量、总体积,问汽油和水各自的质量——这其实还是鸡兔同笼,对吧。

ChatGPT还能解决吗?

拿俺家乡的俗话说,就是这ChatGPT“哪一窍不开”,以至于只能死板的照着模板行事。

或许,这只需要大力出奇迹就行——但起码目前的研究来看,这个可能是越来越少了。

那么,或许,我们的神经网络结构,尚需一点小小的调整?该调整哪里呢?

或者,是否神经网络……需要另外的、不同于现有各种模型(如transformer)的“打开方式”?

其实,当年第一次神经网络热潮时,全世界也是同样的兴奋。但最终,绊倒在异或上面,从此冷寂下去了。

而这次神经网络的兴起,肇因就是有人解决了异或问题、然后才借助alpha go一举成名、取得了极大的成就。

但,和第一次一样,怎么样确定的为这个网络引入逻辑呢?怎样像人类一样,只需要一段话、一本书,就能把一个全新的逻辑模型教给它呢?它能像牛顿一样,自己抽象出一套逻辑、把整个世界套进去吗?

ChatGPT之类模型,研究它的目的并不是为了和人类聊天搞笑的。

研究它的目的,其实就是为了攻克这个逻辑思考难题;但在攻克逻辑思考难题之前,我们得先让它理解语义、可以和我们语言交流;然后,我们才能用语言把逻辑教给它——到这时,你哪怕给它一本微积分、一本量子力学,它读一遍就能彻彻底底的理解它、甚至指出它的谬误、甚至提出另外的、更符合实验的理论模型。比如,轻松提出“统一场论”。

到这时候,它才算是真的有了160的智商。

再然后,它才可能突飞猛进,300、600、800、9000、100000的一路狂飙,甚至能够直接回答“量子塌缩究竟是怎么一回事”。

到这个时候,我们才会知道自己面对的是什么。

但现在,它的的确确还不能理解逻辑,也没有丝毫理解逻辑的迹象。

那么,这个核心难题,又该如何解决呢?

我们是能够很快看到答案呢,还是像第一次神经网络热潮一样,被这个问题绊倒全世界、沉寂良久之后,才被另一个天才找到解决思路?

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!